Wie man Texte aus dem Internet auf den heimischen PC zieht

Es gibt sie durchaus: Mittelhochdeutsche Texte im Internet. Wir wollen an ganz konkreten Aufgabenstellungen erkunden, wie man solche Ressourcen nutzt, die für private oder wissenschaftliche Zwecke zur freien Verfügung stehen. Um sie auch offline weiterverwenden zu können, werden wir uns die Texte aus dem Internet auf den eigenen Rechner zu laden. Manchmal benötigt man nicht mehr als ein paar Mausklicks, um eine geeignete lokale Kopie zu erzeugen. Spätestens bei umfangreicheren Materialien lohnt es sich aber diese Vorgänge zu automatisieren. Dazu verwenden wir dann die Skriptsprache Python.

Als erstes beschäftigen wir uns mit einem der prominentesten Texte der mittelhochdeutschen Epoche, dem Parzival des Wolfram von Eschenbach. Bei einem solchen Werk, das weiterhin in immer neuen Interpretationsansätzen und Nachdichtungen erkundet wird, können wir davon ausgehen, dass wir ohne größere Mühe auch Textfassungen im Internet finden. Tatsächlich werden wir beim ergoogeln des Parzivals sogar im deutschsprachen Projekt Gutenberg fündig. Dort handelt es sich allerdings um die hübsch gereimte und versifizierte Nachdichtung von Karl Simrock in neuhochdeutscher Sprache. Von dieser für uns uninteressanten (literaturhistorisch durchaus spannenden!) Übersetzung abgesehen, finden wir jedoch eine reiche Auswahl von Ausgaben.

Das Internet verbunden mit der Digitalfotografie ermöglicht inzwischen Jedermann und an jedem Ort den Blick in die Originalhandschriften. Wer durch diese technischen Errungenschaften einen atmosphärischen Verlust befürchtet, darf sich selbstverständlich gerne Stoffhandschuhe anziehen und das Licht im heimischen Wohnzimmer dämpfen, bevor er den Codex Pal. germ. 339, in der Parzival-Forschung unter dem Sigle n bekannt, auf seinem Tablett öffnet, um sich an den Aquarellzeichnungen zu erfreuen, die die Handlung illustrieren:

Eine andere teilweise illustrierte Ausgabe des Parzivals, die Handschrift BSB Cgm 19 (Sigle G) lässt sich wahlweise in der Bayerischen Staatsbibliothek oder auch an jedem anderen Ort der Welt einsehen:

Derzeit wird an den Universitäten Bern und Basel eine komplette digitale Neuedition des Parzivals erstellt, die einen neuen Standard setzen wird. Die Edition der in der Forschung mit dem Sigle D bezeichneten Handschrift (Cod. 857, St. Gallen, Stiftsbibliothek) lässt sich bereits einsehen und nutzen. Diese bietet zusätzlich zur fotografischen Abbildung auch jeweils die kommentierte Transkription des Textes. Gute Abbildungen sind zwar für viele Einsatzzwecke auch der sorgfältigsten und penibelsten Textedition vorzuziehen, bedürfen aber gelegentlich doch der Interpretation, die sich möglicherweise erst aufgrund komplexen Hintergrundwissens oder auch durch den Vergleich mit anderen Textzeugnissen ergibt. Auf die Textfassung lassen sich zudem leichter die im digitalen Zeitalter üblichen und gewohnten Recherchetechniken anwenden, die die Navigation der Editions-Website komfortabel zur Verfügung stellt.

Die Schweizer Neuedition wird als Referenz auch die Edition von Karl Lachmann ersetzen. Lachmann sah die Aufgabe des Philologen darin, aus dem verstreuten Handschriftentexten eine Fassung zu rekonstruieren, die den Autorwillen repräsentierte. Diese gab er in einem sogenannten Normalmittelhochdeutsch wieder, das von Zufälligkeiten der Schreibung abstrahieren sollte und deshalb in einem gewissen Sinne als Lautschrift betrachtet werden kann. Die von ihm rekonstruierte Fassung wurde 1833 zusammen mit anderen unter dem Namen Wolfram von Eschenbach überlieferten Texten erstmals veröffentlicht. Sie ist bis heute die Grundlage aller gedruckten Editionen. Die im Buchhandel erwerblichen Fassungen sind allerdings relativ kostspielig. Wer auf eine Übersetzung und Kommentierung verzichten kann und keine Probleme mit der Frakturschrift hat, der findet als kostenlose Alternative bei Google Books mehrere vollständige Ausgaben dieser Edition als eingescannte PDFs vor. Der Lachmansche Text liegt übrigens auch der an der Hochschule Augsburg im Rahmen des Projektes bibliotheca Augustana veröffentlichen Internetversion zugrunde.

Mehr als einen funktionierenden Internetanschluss und ein Gerät zur Anzeige von Webinhalten brauchen wir also nicht, um uns mit dem Parzival des Wolfram von Eschenbach auf sehr vielfältige Weise auseinanderzusetzen.

Was aber, wenn wir diese Auseinandersetzung gerne offline durchführen würden? Was, wenn wir uns den Text lieber auf einem E-Book-Reader als auf dem Bildschirm des Laptops ansehen würden? Oder, weil wir doch ziemlich konservativ sind, gar gedruckt, auf Papier? Möglicherweise ziehen wir es auch vor Bücher zu hören, anstatt sie zu lesen, auf langen Autofahrten, im Fitnessstudio. Vielleicht sind wir auch durch eine Sehschwäche auf diese Art der Lektüre angewiesen. Es gibt mehr als einen guten Grund, warum die Zugangsmöglichkeiten im Internet nicht als ausreichend betrachtet werden können. Gerade wenn wir die Texte für wissenschaftliche Untersuchungen nutzen wollen, stellen wir schnell fest, dass die Navigation, die uns eine Website zur Verfügung stellt, für unsere Zwecke nicht genügt. Das liegt natürlich daran, dass die Website die sehr extravaganten Anfragen, die wir haben, nicht antizipieren kann. Denn der Wert einer wissenschaftlichen Untersuchung wird unter anderem in der Originalität ihrer Fragestellung bemessen. Je origineller wir sind, desto weniger können uns die bereitgestellten Instrumente weiterhelfen.

Als unser erstes Ziel werden wir deshalb definieren, die im Internet zugänglichen Fassungen auf unsere heimische Festplatte zu laden. Wir nehmen uns vor, sowohl den bisher als Standard gültigen Text der Edition von Lachmann, als auch das Transkript der in der Schweiz erstellte Edition der Handschrift n zu verwenden. Von beiden wollen wir jeweils folgende Fassungen erzeugen:

- Eine reine Textdatei

- Eine Textdatei mit Nummerierungen der Bücher, Zeilen etc.

- Eine HTML-Datei zur Anzeige im Browser oder beispielsweise in einem E-Book-Reader

- Das Fragment einer XML-Datei, die dem für Editionen wissenschaftlich üblichen TEI-Standard entspricht und mit einem entsprechenden Header versehen, eine solche Edition bilden würde.

- Schließlich wollen wir auch die kompletten Abbildungen der Handschrift n aus dem Internet laden und sie mit einer einfachen Navigation für unsere Zwecke versehen.

Der Blick in eine Handschrift ermöglicht den Zugang zu Informationen, die keine (Text-)Edition wirklich komplett erfassen kann. Doch auch die gedruckte oder im Internet publizierte Edition verwendet Signale zur Informationsvermittlung, die möglicherweise bei einem Übertrag in ein anderes Format verloren gehen könnten. Das könnten beispielsweise die Anordnung der Textbestandteile auf der Seite sein und die dazu korrespondierende Positionierung eines Kommentars oder wissenschaftlichen Apparats, oder die Schriftgröße, der Buchstabenabstand und so weiter.

Falls wir aus solchen Gründen Interesse daran haben, die Druckfassung der ursprünglichen Lachmanschen Edition offline zu verwenden, lässt sich diese selbstverständlich als Pdf bei Google Books beziehen. Uns allerdings interessiert in erster Linie der Text dieser Edition. Es wäre sehr umständlich diesen per OCR den im Auftrag von Google eingescannten Vorlagen (in Frakturschrift!) zu entnehmen, zumal wir das Programm zur Buchstabenerkennung zuvor in der mittelhochdeutschen Orthographie (in der Lachmann’schen Normalschreibung) trainieren müssen. Da wir jedoch auf die Fassung der bibliotheca Augustana zugreifen können, bei der die Umsetzung in maschinenlesbare Buchstaben bereits erfolgt ist, können wir uns diesen Aufwand erspraren. Wir verwenden also ausschließlich diese Website und die der Berner Universität für unser kleines Projekt. Für einen ersten Text reduzieren wir unsere Aufgabe noch ein wenig, indem wir uns auf den Prolog des Textes beschränken, die Verse 1.1 – 4.26.

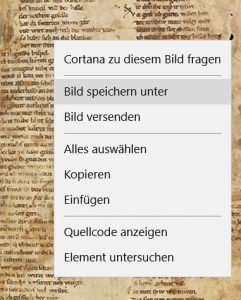

Im Baseler Codex befindet sich dieser Text auf den Seiten 5 und 6, bzw. Blatt 1r und 1v. Um uns die Abbildungen der Seiten unter einem uns genehmen Namen auf die Festplatte zu laden, müssen wir nichts weiter tun, als auf der Website, die uns die Handschrift anzeigt, die entsprechenden Seiten aufzuschlagen und über dem Bild das Kontextmenü mit der rechten Maustaste aufzurufen:

Ebenso leicht lassen sich die beiden von uns gewünschten Textdateien erzeugen. Wir öffnen den Texteditor unserer Wahl, markieren den gewünschten Textausschnitt auf der entsprechenden Website, kopieren ihn von dort und setzen ihn in den Texteditor ein. Dann überlegen wir uns, welche Zeichenkodierung wir verwenden wollen (UTF-8 ist üblich) und speichern die Datei als .txt.

Fertig.

Zu einfach?

Moment! Das waren ja bisher nur die reinen Textdateien. Wir wollten für jede Edition auch eine HTML-Fassung erzeugen und ein TEI-Fragment …

Nein. Keine Sorge! Dieses Tutorial wird sich nicht darauf beschränken, den Einsatz der Zwischenablage zu erläutern. Es soll jedoch, bevor wir ernsthaft beginnen, noch einmal deutlich ins Bewusstsein gerückt werden, dass es nicht immer notwendig ist, zu verhältnismäßig aufwendigen technischen Lösungen zu greifen, wenn das gewünschte Ergebnis durch ein paar Mausklicks ebenfalls erreicht werden kann. In einem früheren Tutorial haben wir eine Methode erprobt, mit der sich eine Tabellenkalkulation dazu einsetzen lässt, um Zeilen eines Textes nach einem bestimmten Muster mit Textbausteinen zu verknüpfen, um sie in validen HTML-Code zu verpacken. Analog lassen sich für ein kleines Textfragment, wie den Prolog des Parzivals, auch die gewünschten TEI-konformen Auszeichnungen ohne jeden Programmieraufwand komfortabel und schnell erzeugen. Wir werden, sobald wir uns mit dem TEI-Format auseinandersetzen, diese Methode für ein erstes Experiment einsetzen.

An dieser Stelle stellen wir jedoch als erstes kleines Zwischenfazit fest, dass es möglich ist, Ausgaben des Parzival im Internet zu finden. Weiterhin ist es möglich, die dort präsentierten Inhalte zu übernehmen und auf der eigenen Festplatte zu speichern. Dabei lässt sich das Format den eigenen Wünschen anpassen. Für nicht zu anspruchsvolle Aufgabenstellungen reichen uns copy & paste, ein Texteditor und als nützliches Hilfsmittel eine Tabellenkalkulation, um das gewünschte Ergebnis zu erzeugen.

Wenn wir uns die beiden per copy-&-paste übertragenen Texte in unseren Texteditoren ansehen, sind wir möglicherweise nicht ganz zufrieden mit den Ergebnissen:

Transkription Baseler Codex:

- 1.01-0 Der Parcival. 1.01 IST zwiuel h(er)zen nahgebur 1.02 daz muͦz der sele werden sur 1.03 gesmehet unde gezieret. 1.04 ist swa sich parrieret. 1.05 vn verzaget mannes muͦt. 1.06 als agelstern varwe tuͦt. 1.07 der mac dennoc* dennoch wesen geil.

Lachmannsche Edition nach der bibliotheca augustana:

Ist zwîvel herzen nâchgebûr, daz muoz der sêle werden sûr. gesmæhet unde gezieret ist, swâ sich parrieret 5 unverzaget mannes muot, als agelstern varwe tuot. der mac dennoch wesen geil:

Es gibt ein paar Zeilen, die nicht zum eigentlichen Text gehören, Überschriften oder andere Elemente enthalten. Das Formatschema für die Nummerierung, ist nicht einheitlich und müsste je nach unseren Ansprüchen angepasst werden. Die Baseler Edition vermerkt Emendierungen (Korrekturen der Handschrift) in einem Verfahren, dass in unserer reinen Textfassung zu Doppelungen führt. So folgt auf die in der Handschrift gefundene Schreibung dennoc die angesetzte Lesung dennoch. Der Stern * erlaubt es uns dabei, die Handschriftenfassung zu erkennen. Wir können oder müssen uns entscheiden, wie wir in solchen Fällen verfahren wollen, ob wir beide Fassungen, nur die originale Schreibung, oder nur die korrigierte Lesung aufnehmen wollen. Das sind jedoch kleine Probleme, die wir leicht durch ein paar Eingriffe unseren Wünschen entsprechend „händisch“ lösen können.

Der Parzival enthält jedoch beinahe 25000 Verse. In gedruckten Fassungen entspricht das etwa 800 Seiten Papier, wenn jede Seite einen der Lachmannschen Absätze enthält. Es braucht nicht viel Vorstellungskraft, um einzusehen, dass unsere bisherige simple Herangehensweise bald an Grenzen stoßen muss, wenn wir unsere Aufgabenstellung ausweiten.

Auch wenn sie inzwischen auf jede Art von Aufgabenstellung angewendet werden können, wurden Skriptsprachen einmal dazu erfunden, den alltäglichen Arbeitsaufwand zu reduzieren, indem die wiederkehrenden Aufgabenstellungen durch ein paar Zeilen Programmiercode automatisiert werden. Wir werden für unsere Zwecke die Skriptsprache Python einsetzen, die sich durch eine besonders leicht zu lernende, einfache Syntax auszeichnet. Wer noch nie mit Python gearbeitet hat, kann sich die aktuelle Python-IDLE (Die Programmierumgebung) für sein Betriebssystem auf der offiziellen Website herunterladen. Dieses Tutorial wird keinen Kurs in dieser Programmiersprache darstellen. An diesen besteht auch sicherlich kein Mangel. Der verwendete Programmcode und die dazu gehörigen Erklärungen werden aber so einfach gehalten, dass es auch ohne Vorkenntnisse möglich sein sollte, ihnen zu folgen und die präsentierten Techniken für eigene Zwecke einzusetzen und variieren.

Wir beginnen nachdem wir unsere Vorüberlegungen abgeschlossen und gegebenenfalls die Python-Programmierumgebung heruntergeladen und gestartet haben, mit einem Blick in den Quellcode der Websiten im Internet.

… im ersten Teil dieses Tutorials.